Czy potrafisz zaprzyjaźnić się z algorytmem – i czy w ogóle powinieneś?

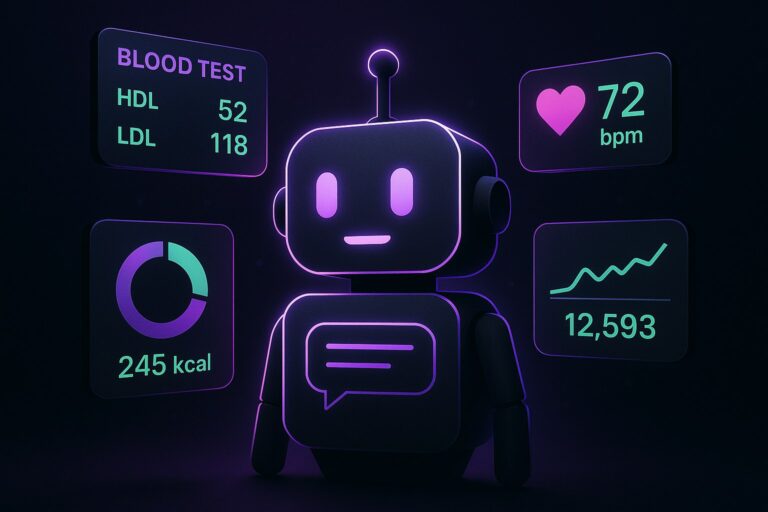

Była lekarka Jenny Shao rzuciła rezydenturę na Harvardzie, by zbudować Robyn – „empatycznego” towarzysza AI, który ma rozumieć emocje, ale nie udawać terapeuty. Aplikacja startuje w USA na iOS i wchodzi w tłumne, drażliwe terytorium między chatbotami do wszystkiego a „przyjaciółmi z chmury”.

Dlaczego to ważne? Samotność stała się problemem zdrowia publicznego, a towarzysze AI rosną szybciej, niż większości z nas wygodnie przyznać. W lipcu badanie pokazało, że wielu amerykańskich nastolatków korzystało już z aplikacji tego typu. Jednocześnie to przestrzeń najeżona ryzykiem i pozwami – w tym tymi łączącymi użycie botów z tragediami. Wejście do niej kogoś, kto zna medycynę od środka, zmienia akcenty: mniej „wow”, więcej „czy to bezpieczne?”.

Lekarka, która zamieniła oddział na kod

Shao mówi wprost: pomysł dojrzewał w pandemii, kiedy izolacja pacjentów miała realny, neurologiczny ciężar. Widziała, jak długie miesiące samotności wykrzywiają nastrój i poznanie. To nie jest anegdota z LinkedIna, tylko echo szerszego alarmu: amerykański Surgeon General powiązał powszechną samotność z gorszymi wynikami sercowymi, poznawczymi i psychicznymi, a WHO podniosła „więź społeczną” do rangi globalnego priorytetu. W tym kadrze Robyn nie jest kaprysem startupu, tylko próbą wypełnienia dziury między systemem ochrony zdrowia, który nie nadąża, a użytkownikami, którzy potrzebują rozmowy teraz, nie za sześć tygodni. [3]

Pomiędzy przyjaźnią a terapią

Rynek, na który wchodzi Robyn, jest zatłoczony i mętny. Z jednej strony mamy generalistów pokroju ChatGPT, z drugiej – towarzyszy i awatary: Character.AI, Replika, Friend. Do tego „terapeutyczne” aplikacje, jak Feeling Great. Granice między wsparciem, rozrywką i poradnictwem są tu cienkie, a stawka bywa wysoka. To nie przypadek, że niektóre z tych usług przewijają się w pozwach dotyczących samobójstw.

Shao stawia swoje drogowskazy jasno. „Jako lekarka widziałam, jak źle się kończy, gdy firmy technologiczne próbują zastąpić twojego lekarza” – mówi. I dodaje, że Robyn „nie jest i nie będzie” substytutem klinicysty. A więc nie psychoterapeuta, nie medyczny konsultant, nawet nie „przyjaciółka” w sensie aplikacji budującej relacje jak gra. Ma być kimś „kto zna cię bardzo dobrze” – rozmówcą z empatią i pamięcią kontekstu, ale z wyraźną tabliczką „to nie terapia”. [2]

Pamięć jak u ludzi (albo prawie)

Co wyróżnia Robyn poza deklaracjami? Architektura pamięci. Shao pracowała naukowo nad pamięcią w laboratorium noblisty Erica Kandela – nad tym, jak doświadczenia kodują się biologicznie. Robyn nie „ma mózgu”, ale wykorzystuje te zasady projektowo: buduje wspomnienia o użytkowniku i przywołuje kontekst w sposób bliższy ludzkiemu niż standardowy „czat od zera”. Czyli: pamięta, jak mówisz o swojej siostrze, rozumie, że „jutro” w twoim kalendarzu to ważny sprawdzian, i nie pyta pięć razy o to samo. Brzmi jak detal, ale w rozmowach o emocjach ciągłość to połowa empatii. [3]

Drugą połowę stanowi bezpieczeństwo. Twórcy podkreślają „medycznie poinformowane” podejście do ryzyka: Robyn ma być wsparciem, nie diagnozą, i działać z wyraźnymi granicami. To deklaracja tyleż oczywista, co konieczna. W tej kategorii każdy produkt balansuje nad przepaścią między użytecznością a nadmiernym zaufaniem. Jeśli aplikacja zacznie doradzać ponad kompetencje albo wzmacniać kryzys zamiast deeskalować, kończy się to źle – nie tylko w PR.

Fakty, które trzeba znać

Robyn debiutuje w USA jako aplikacja na iOS. Pozycjonuje się jako „empatyczny” towarzysz, nie „terapeuta na skróty”. Powstanie projektu to efekt pandemii i obserwacji neurologicznego wpływu izolacji na ludzi. Konkurencja: od chatbotów ogólnych po aplikacje-towarzyszy i „terapie w pudełku”. W tle – rosnące użycie tego typu narzędzi wśród nastolatków oraz głośne sprawy, w których interakcje z botami są wiązane z dramatami. I wreszcie: ambicja odróżnienia się przez pamięć kontekstową inspirowaną nauką o pamięci. Na dziś firma nie ujawnia parametrów modelu (liczba miliardów), długości kontekstu tokenów, wyników benchmarków, licencji ani wymagań sprzętowych lub stosu obliczeniowego. [3]

Czy to zadziała?

Z jednej strony, timing jest trafiony. Zapotrzebowanie na „kogoś, kto wysłucha” nie spada, a systemy ochrony zdrowia mają limity. Z drugiej – to grząski grunt. Użytkownicy bardzo szybko traktują boty jak ludzi, a wtedy nawet najgrubszy disclaimer bywa niewidzialny. Różnica między „rozumiem, że jest ci trudno” a „zrób X, żeby przeszło” to cienka linia – i właśnie jej pilnowanie rozstrzygnie, czy Robyn będzie wsparciem, czy kolejnym problemem do ogarnięcia.

Ciekawy jest też ruch „od medycyny do produktu”. W erze, gdy aplikacje bez żenady udają terapeutów, posiadanie za sterem kogoś, kto zna kliniczne skutki złych porad, jest realną przewagą. To nie gwarancja nieomylności, ale szansa, że mechanizmy bezpieczeństwa będą traktowane poważnie. Jeśli dołożymy do tego pamięć projektowaną pod relację – a nie tylko pod poprawną odpowiedź – Robyn może stać się przykładem, jak budować narzędzia pro-wellbeing bez wpadania w medyczne cosplaye.

Granice, granice, granice

Największe pytanie dotyczy praktyki: jak Robyn reaguje na treści wysokiego ryzyka, jak eskaluje, kiedy odsyła do człowieka, co i jak pamięta, i czy użytkownik ma nad tym kontrolę. To detale, które decydują o zaufaniu. Druga sprawa: dla nastolatków i osób w kryzysie granica między „towarzyszem” a „autorytetem” jest płynna. Jeśli już dziś wielu młodych korzysta z takich narzędzi, to jest to de facto infrastruktura emocjonalna – i jako taka powinna działać z większą odpowiedzialnością niż przeciętny social.

Na koniec mała metafora: to, co próbuje zrobić Robyn, to miękkie lądowanie między „przyjaciółką z telefonu” a „terapeutą na tapecie”. Jeśli się uda, może to być pożyteczne narzędzie dla wielu. Jeśli nie – skończy jak wiele botów przed nią: z ładnym onboardingiem, długim regulaminem i krótką pamięcią, która zapomina, po co to wszystko było.

Podsumowanie

Robyn wchodzi w najtrudniejszą klasę produktów AI: tych, które dotykają emocji. Ma sensowny rodowód, mądrą deklarację roli i ciekawą, „ludzką” pamięć. Pytanie, które zostaje, jest proste: czy to wystarczy, by pomóc – i nie zaszkodzić – gdy naprawdę robi się ciężko? Odpowiedź, jak zwykle w technologii, zależy mniej od obietnic, a bardziej od tego, jak działa każdy dialog, każda reakcja i każde „nie wiem, porozmawiaj z człowiekiem”.